A Inteligência Artificial (IA) causou grande polêmica após começar a criar imagens que enganam e também fascinam o ser humano. Além de fotos realistas, já usadas para promover fake news, também tiveram bons resultados em concursos de arte. Agora a IA também está sendo usada para gerar identidades falsas.

Em um experimento realizado pelo portal 404 Media, as falsas identidades foram usadas para passar pelos programas de KYC (sigla inglesa para Conheça Seu Cliente) de corretoras de criptomoedas. As identidades falsas foram aprovadas.

Essa técnica pode atrair a atenção de criminosos que buscam lavar criptomoedas ligadas a hacks, por exemplo, quebrando o rastro das transações. Portanto, o usuário comum pode esperar novos sistemas de verificação de identidade mais rígidos no futuro.

Identidade falsa criada por IA custa R$ 75 e engana corretoras de criptomoedas

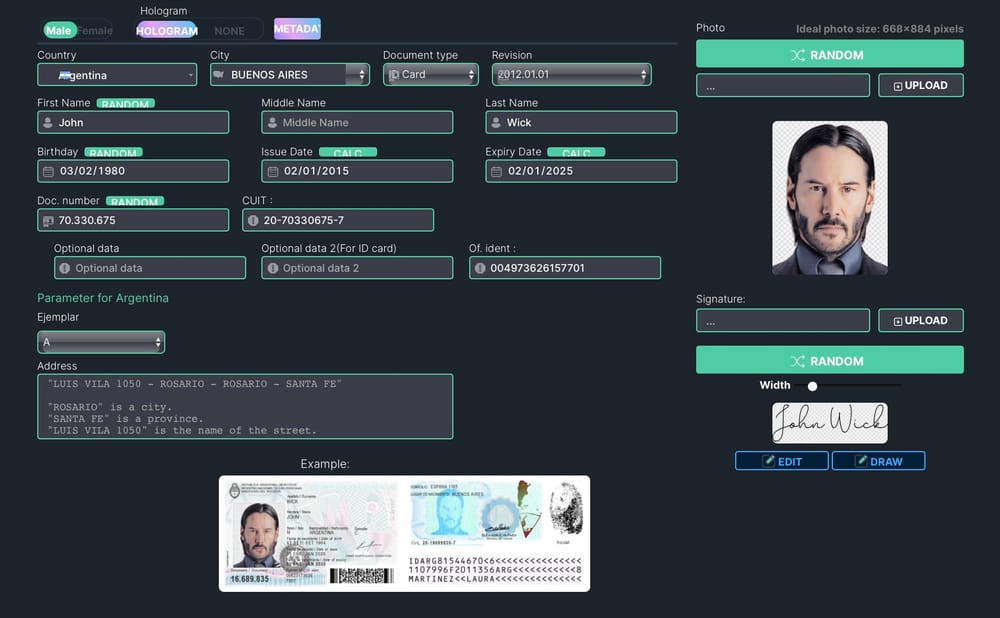

Embora muitas ferramentas de IA não apresentem bons resultados com textos, a 404 Media afirma que as identidades falsas foram criadas em um site chamado OnlyFake. O custo é de US$ 15 (R$ 75) e os resultados são rápidos e impressionantes.

“Em vez de criar meticulosamente uma identidade falsa à mão ou esperar que uma identidade comprada chegue pelo correio com o risco de interceptação, OnlyFake permite que qualquer pessoa gere identidades falsas em minutos”, apontou a 404 Media. “Parecem reais o suficiente para contornar vários sistemas de verificação online.”

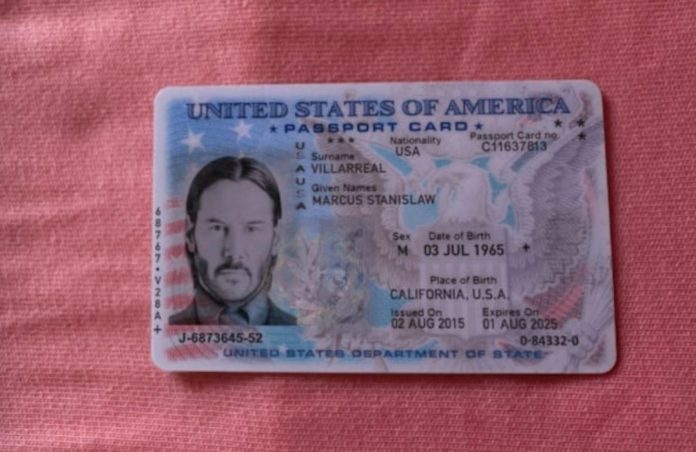

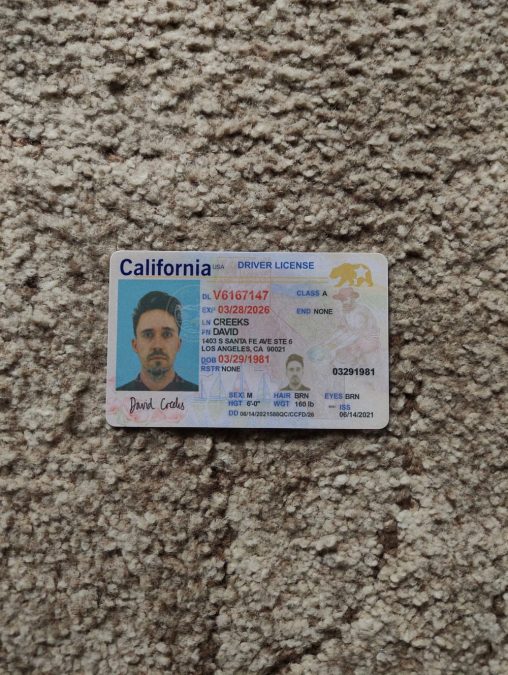

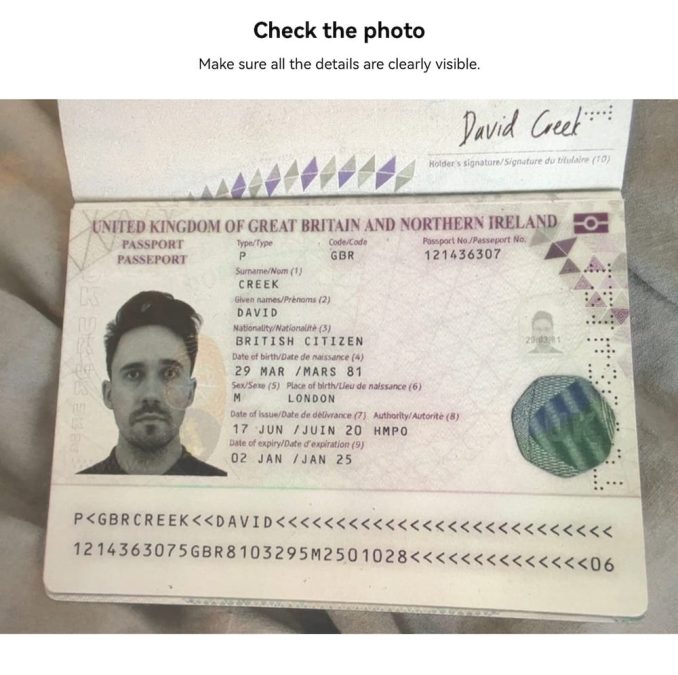

“Os fundos das imagens — o tecido, a superfície — fazem parecer serem fotos reais.”

Conforme todos os dados são inseridos pelo usuário, incluindo a foto, isso significa que a verificação de identidade pode passar por testes mais extremos, como o cruzamento de informações com outras bases de dados. Um verdadeiro perigo já que pessoas inocentes podem ser acusadas por crimes que não cometeram.

Com a falsa identidade em mãos, figurativamente, a 404 Media criou uma conta na corretora de criptomoedas OKX e enviou as fotos para o processo de KYC.

“O processo começou com OKX me pedindo para tirar uma foto do documento de identidade com a câmera de um smartphone”, comentou Joseph Cox, jornalista por trás do experimento. “Funcionou, mesmo que eu não tivesse uma identidade física em mãos.”

“Apontei a câmera para a foto gerada pelo OnlyFake da identidade falsa exibida na tela do meu laptop e o sistema reconheceu a identidade com sucesso. Então ela me pediu para tirar uma selfie.”

Sem surpresa, o documento foi aceito e a selfie também, já que Cox usou sua própria foto no documento. “Parabéns! Você concluiu sua verificação de identidade”, informou o site da corretora. Embora a OKX não tenha respondido ao artigo até o momento, é notável que isso ameaça todas empresas do setor financeiro.

“O proprietário do OnlyFake, Wick, disse à 404 Media que seu serviço poderia ser usado para contornar a verificação em vários sites, incluindo Binance, Revolut, Wise, Kraken, Bybit, Payoneer, Huobi, Airbnb, OKX e Coinbase.”

IAs apenas agilizam fraudes que já existem antes mesmo da internet

Como destacado, grandes criminosos já tinham acesso a identidades falsas há décadas. No entanto, precisam contar com serviços de profissionais de difícil acesso, que poderiam cobrar valores extremamente altos.

Portanto, as inteligências artificiais parecem estar apenas agilizando as fraudes e emponderando criminosos que até então não forneciam grandes ameaças. Outra técnica que poderia ser acrescentada é o deepfake, podendo contornar ferramentas extras de verificação.

Por fim, vale destacar que nem todos acreditam que a OnlyFake esteja usando IA em seu sistema. Para o professor Hany Farid, eles “teriam problemas com inconsistências no plano de fundo” e, portanto, podem apenas estar inserindo/alterando dados em modelos de documentos já prontos.

De qualquer forma, usuários honestos já podem se preparar para enfrentar verificações de identidades mais abusivas em corretoras de criptomoedas. Afinal, os processos atuais de KYC não parecem tão efetivos como eram antes.